Dans un monde économique en mutation rapide, le changement climatique n’est plus une menace lointaine, mais un paramètre stratégique immédiat. Chaque décision d’investissement, chaque évaluation de risque devient un exercice de haute précision où la donnée géospatiale se transforme en véritable boussole stratégique. Exploiter ces données géospatiales relève pourtant du parcours du combattant. La complexité technique inhérente à ces données nécessite une expertise pointue que peu d’organisations possèdent en interne. Entre la multitude de sources disponibles, les complexités techniques et les volumes de données astronomiques, transformer la donnée brute en intelligence opérationnelle nécessite une véritable stratégie.

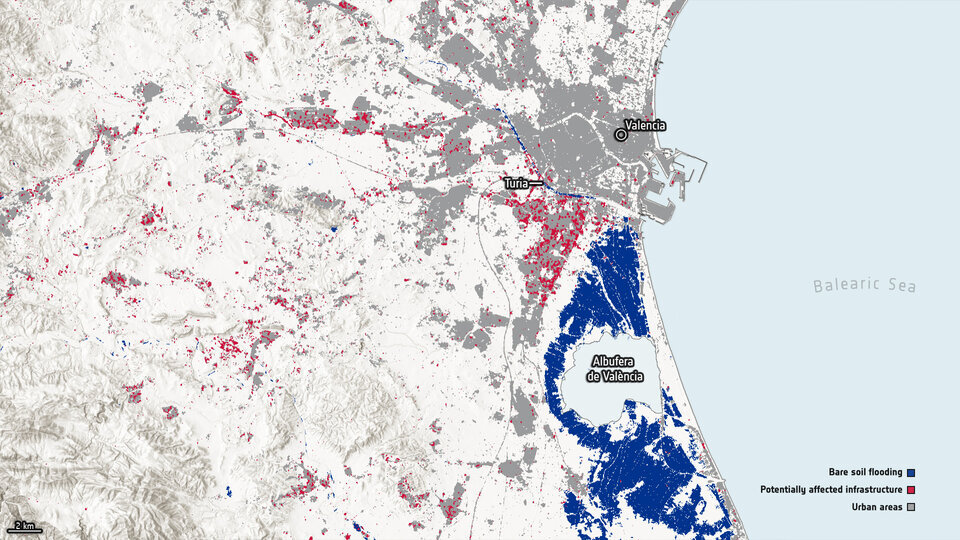

Inondations de la région de Valence 2024 (source ESA)

Des formats de données spécifiques

Les données géospatiales représentent un écosystème riche et diversifié, structuré autour de plusieurs typologies fondamentales. Les données décrivant des géométries précises – bâtiments, localités, cours d’eau – permettant des analyses spatiales complexes sont stockées dans des formats vectoriels respectant les géométries comme shapefile ou GeoJSON. L’observation satellitaire fournissant des images spectrales haute résolution utilisées pour le risk monitoring ou la détection d’occupation des sols seront stockées sous formes de rasters comme GeoTiff, ou des nuages de points LIDAR utilisés pour la topographie au format LAS. Les modélisations climatiques globales comme CMIP6 ou régionales comme Safran fournissant des reconstructions historiques et des projections futures essentielles pour la planification stratégique seront des données cube comme NetCDF ou HDF, représentant l’espace et le temps sous forme de grilles multi-dimensionnelles.

Chacune de ces typologies consiste en une structuration différente des données, qui offre des avantages et des optimisations uniques. A cette complexité s’ajoute celle de la diversité des sources, produites par organismes et des laboratoires différents, qui possèdent leurs méthodes de traitement et de correction spécifiques, et réalisent des choix différents sur les résolutions spatiales, le calcul des variables ou les scénarios climatiques considérés.

Pour s’y retrouver, faire les bons choix et en comprendre les potentiels limites et biais, une bonne compréhension scientifique des problématiques climatiques est nécessaire.

Des contraintes infrastructurelles : gérer la masse et la dynamique des données géospatiales

Les données géospatiales et climatiques sont souvent particulièrement massives, un seul modèle climatique pouvant par exemple représenter jusqu’à plusieurs téraoctets. De plus ces données sont susceptibles d’être régulièrement mises à jour, complétées ou corrigées. Cela implique de définir une infrastructure technologique cohérente et spécialisée.

Pour répondre aux volumétries une stratégie de stockage plus poussée et innovante que pour des besoins traditionnels doit être développée. La gestion de données fragmentées sous forme d’arborescences de fichiers implique des défis complexes de gestion des chemins, des autorisations et des métadonnées, auxquels des scripts d’automatisation spécifiques peuvent répondre.

Dans les environnements cloud comme Azure, AWS ou GCP, la gestion fine des buckets devient un enjeu stratégique. Les politiques d’accès granulaires (IAM roles, bucket policies) doivent être pensées pour sécuriser l’accès aux données sensibles tout en facilitant leur exploitation. Les mécanismes de versioning permettent de conserver l’historique des modifications, critique pour les séries climatiques longues.

L’utilisation de bases de données géospatiales comme PostGIS permet de centraliser les données de type vectoriel tout en profitant de fonctions optimisées, tirant parti des avantages de l’indexation spatiale hiérarchisée, pour transformer et croiser les données entre elles.

La gestion des ressources computationnelles devient stratégique. Les mécanismes de mise en cache permettent d’alléger les temps de traitement. L’objectif est de minimiser les temps d’accès tout en maintenant la cohérence des données. La clé réside dans la capacité à concevoir des architectures intelligentes, capables de gérer la complexité et le volume des données géospatiales tout en maintenant des performances optimales et des coûts maîtrisés.

Cloud storage (Source : turningcloud)

Les défis techniques de la manipulation

Le traitement des données géospatiales représente un défi technique complexe qui dépasse largement le cadre data traditionnel : la valeur ajoutée réside le plus souvent dans la capacité de fusionner des sources hétérogènes, transformant des jeux de données isolés en écosystèmes informationnels riches. Cette fusion impose des transformations techniques sophistiquées, nécessitant une expertise fine dans plusieurs domaines critiques.

La gestion des systèmes de projection cartographique (CRS) constitue un premier niveau de complexité. Chaque source de données utilise potentiellement un référentiel géographique différent, imposant des transformations mathématiques pour garantir la cohérence spatiale. L’harmonisation des résolutions spatiales et temporelles représente un défi tout aussi stratégique : comment croiser des données satellitaires à 10m de résolution avec des modélisations climatiques de plusieurs km de résolution ou des relevés météorologiques ponctuels ?

L’interpolation entre points de mesure nécessite des algorithmes avancés, capables d’estimer des valeurs manquantes tout en préservant la signature statistique originelle. La validation de la cohérence des données devient alors cruciale, nécessitant des contrôles multicritères pour détecter anomalies et incohérences.

Ces problématiques requièrent la maîtrise d’outils hautement spécialisés comme la librairie xarray pour les séries multidimensionnelles, rasterio pour le traitement des images géographiques, ou GDAL pour les transformations de systèmes de coordonnées. Ces librairies Python dépassent le cadre des frameworks de data science généralistes, exigeant une expertise technique à l’intersection de la géomatique, des statistiques et de l’ingénierie des données.

Enrichir sa vision en croisant les informations : la donnée géospatiale multicouche (Source : GIS and Environmental Monitoring, Kollos et al., 2017)

L’émergence de solutions innovantes

De nouvelles pratiques, de nouveaux outils émergent continuellement, apportant des solutions aux problèmes rencontrés ou proposant des optimisations. Parmi ceux-ci, des formats de données pensés pour profiter des avantages du cloud, dits formats coud-native ou cloud-optimized, apportent une réponse à l’augmentation continue de la taille et de la complexité des données géospatiales. Ils ont en commun de fragmenter les blocs de données, traditionnellement monolithiques, en ensembles de petits éléments, tout en conservant une vue d’ensemble en accompagnant les sous-éléments d’un fichier centralisé de métadonnées, décrivant leur contenu et pointant vers leur adresse.

Les données de type vectoriel sont alors stockées au format geoparquet, proposant une compression optimisée et un traitement en colonne des tableaux de données qui facilite et accélère l’accès aux sous-parties. Le système de gestion de bases de données DuckDB, également orienté colonne, offre une synergie particulièrement efficace avec geoparquet, et propose même des fonctions spatiales optimisées ! Les données de type raster seront elles stockées au format Zarr, qui découpe les blocs géospatiaux en ensembles de chunks pouvant être regroupés de manière hiérarchique.

À travers un mécanisme de lazy-loading, il devient alors possible de consulter un aperçu global des données, puis de ne charger que la zone d’intérêt, réduisant significativement les temps de latence et les ressources computationnelles nécessaires et évitant la gestion fastidieuse de systèmes de fichiers. Cette segmentation des données facilite et accélère également le traitement parallèle et distribué à travers des librairies spécialisées, comme Dask, Polars ou Ray, qui conjugué aux possibilités de scalabilité du cloud permet d’accéder à des capacités de calcul jusque-là réservées à des acteurs spécialisés entretenant de coûteuses infrastructures.

Notre expertise à votre service

Si le recourt aux données spatialisées conjugué à une bonne compréhension des problématiques métier se révèle généralement un formidable accélérateur, la montée rapide en complexité face au foisonnement des sources et des solutions existantes implique des compétences avancées dans un ensemble de domaines spécialisés allant de la climatologie au cloud-computing.

Dans un contexte où le climat impacte de plus en plus les décisions business, disposer d’une expertise technique solide dans le traitement des données géospatiales et climatiques n’est plus une option, c’est une nécessité stratégique. La capacité à transformer des données brutes en insights décisionnels devient un avantage concurrentiel déterminant pour les organisations qui sauront anticiper et s’adapter aux défis environnementaux.

Contact

Contact